현대 IT 환경에서 시스템 및 애플리케이션에서 생성되는 방대한 로그 데이터를 효과적으로 수집, 저장, 분석하는 것은 필수적이다. 이에 따라 많은 조직이 을 통해 실시간 모니터링, 장애 진단, 보안 위협 탐지 등을 수행하고 있다. ELK Stack(Elasticsearch, Logstash, Kibana)은 이러한 요구를 충족시키는 오픈소스 기반의 강력한 솔루션으로, 데이터 소스에서 유입되는 로그를 중앙화하고 시각화하여 인사이트를 도출할 수 있도록 지원한다. 본 문서에서는 의 핵심 개념과 실무 적용 방안을 살펴본다.

로그 관리 시스템(ELK Stack) 구축 및 데이터 분석의 핵심 구성 요소

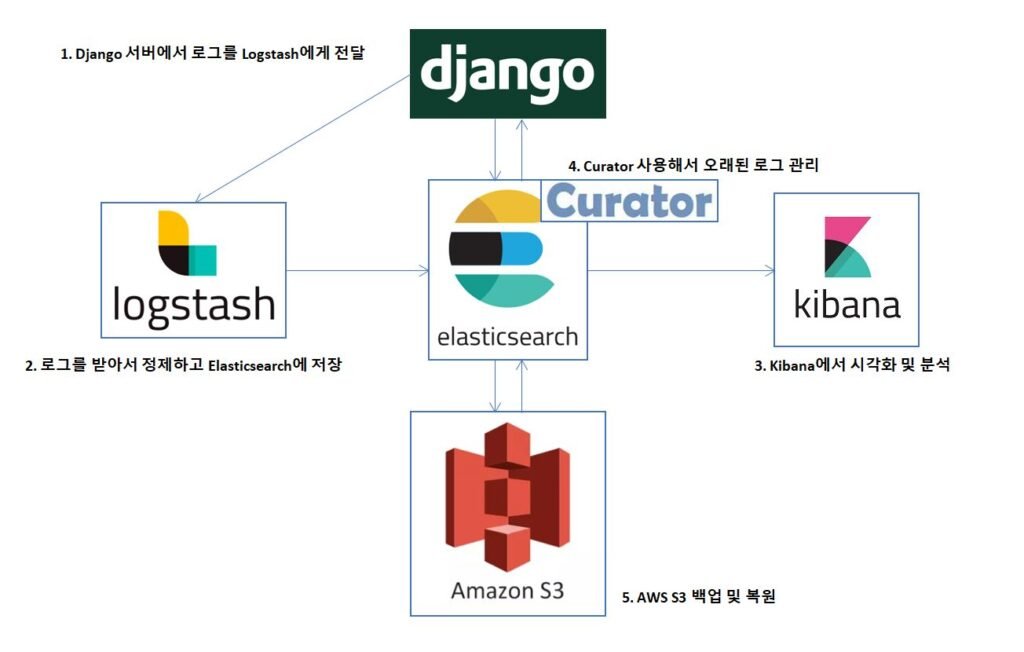

로그 관리 시스템(ELK Stack) 구축 및 데이터 분석은 기업의 IT 인프라에서 발생하는 방대한 로그 데이터를 효과적으로 수집, 저장, 시각화하여 실시간 모니터링과 인사이트 도출을 가능하게 하는 기술적 접근 방식입니다. ELK Stack은 Elasticsearch, Logstash, Kibana의 세 가지 오픈소스 도구로 구성되어 있으며, 각각 역할이 명확히 구분되어 있습니다. Elasticsearch는 고성능 검색 및 분석 엔진으로 로그 데이터를 저장하고 실시간으로 검색할 수 있도록 지원합니다. Logstash는 소스에서 로그를 수집하고 변환하여 Elasticsearch로 전달하는 데이터 파이프라인 역할을 수행합니다. 마지막으로 Kibana는 사용자 친화적인 웹 인터페이스를 통해 데이터를 시각화하고 대시보드를 구성할 수 있게 해줍니다. 이 세 가지 도구의 조합을 통해 조직은 시스템 성능 모니터링, 보안 이벤트 분석, 장애 조기 탐지 등 운영 목적에 맞는 맞춤형 로그 분석 환경을 구축할 수 있습니다.

ELK Stack 구성 요소의 역할과 기능

로깅 인프라를 구축할 때 로그 관리 시스템(ELK Stack) 구축 및 데이터 분석의 핵심은 각 구성 요소의 기능을 정확히 이해하는 데 있습니다. Elasticsearch는 분산형 RESTful 검색 및 분석 엔진으로, 빠른 인덱싱과 검색 성능을 제공합니다. Logstash는 입력 플러그인을 통해 로그 소스(예: 파일, 시스템 로그, 메시지 큐 등)에서 데이터를 수집하고, 필터 플러그인을 사용해 데이터를 정제하며, 출력 플러그인을 통해 Elasticsearch로 전송합니다. Kibana는 이러한 데이터를 기반으로 차트, 그래프, 지도 등을 활용한 시각화를 제공하여 사용자가 로그 데이터를 직관적으로 해석할 수 있도록 돕습니다. 각 요소는 독립적으로도 사용 가능하지만, 통합 사용 시 시너지 효과를 극대화할 수 있습니다.

로그 수집 및 파이프라인 설계 전략

로그 관리 시스템(ELK Stack) 구축 및 데이터 분석을 성공적으로 수행하기 위해서는 로그 수집 전략과 파이프라인 설계가 중요합니다. 우선, 로그 소스의 유형과 형식을 파악하여 Logstash 또는 Filebeat와 같은 Beats 제품을 통해 적절한 입력 방식을 선택해야 합니다. 특히 Filebeat는 가볍고 리소스 소모가 적어 에이전트 기반 수집에 적합하며, Logstash는 복잡한 데이터 변환이 필요한 경우에 유리합니다. 파이프라인 설계 시에는 로그의 우선순위, 처리 빈도, 저장 기간 등을 고려해 인덱스 정책을 수립하고, Grok 필터를 활용해 비정형 로그를 구조화하는 것이 일반적입니다. 이러한 전략은 데이터의 일관성과 분석 정확도를 높이는 데 기여합니다.

Elasticsearch 인덱스 및 클러스터 최적화

로그 관리 시스템(ELK Stack) 구축 및 데이터 분석에서 Elasticsearch의 성능은 전체 시스템의 효율성을 좌우합니다. 대량의 로그 데이터를 처리하기 위해서는 적절한 인덱스 구조 설계가 필요하며, 시간 기반 롤링 인덱스(Rollover Index) 또는 인덱스 라이프사이클 관리(ILM) 정책을 적용해 저장소 사용량과 검색 성능을 최적화할 수 있습니다. 또한, 샤드(Shard) 수를 적절히 설정하고 리플리카(Replica)를 활용하여 장애 복구 능력과 동시 접근 성능을 강화해야 합니다. 클러스터 수준에서는 JVM 힙 메모리 설정, 디스크 I/O 성능, 네트워크 대역폭 등을 종합적으로 고려한 하드웨어 및 설정 조정이 필수적입니다.

Kibana를 활용한 로그 시각화 및 대시보드 구성

로그 관리 시스템(ELK Stack) 구축 및 데이터 분석의 최종 목적 중 하나는 수집된 로그 데이터를 기반으로 실시간 인사이트를 제공하는 것입니다. Kibana는 시각화 도구(예: 라인 차트, 히트맵, 테이블, 지도 등)를 제공하여 사용자가 로그 패턴, 트렌드, 이상 징후 등을 쉽게 파악할 수 있도록 돕습니다. 대시보드는 여러 시각화를 조합해 특정 목적(예: 보안 모니터링, 애플리케이션 성능 분석, 시스템 장애 감시 등)에 맞춘 사용자 정의 화면으로 구성할 수 있습니다. 또한, Kibana의 Alerting 및 Actions 기능을 활용하면 특정 조건 충족 시 알림을 자동으로 전송하는 것도 가능합니다.

보안 및 접근 제어 설정 방법

로그 관리 시스템(ELK Stack) 구축 및 데이터 분석 환경에서는 보안 설정이 간과되어서는 안 됩니다. Elasticsearch와 Kibana는 기본적으로 인증 및 권한 관리 기능이 제한적이지만, Elastic Stack의 Security 기능(또는 X-Pack Security)을 활성화하면 사용자 인증, 역할 기반 접근 제어(RBAC), TLS 통신 암호화 등을 적용할 수 있습니다. 특히 민감한 로그 데이터(예: 인증 로그, 결제 시스템 로그 등)를 처리할 경우, 데이터 접근 권한을 세분화하고 감사 로그를 기록하여 보안 컴플라이언스를 충족해야 합니다. 또한, 방화벽 규칙과 네트워크 분리를 통해 외부 접근을 제한하는 것도 중요한 보안 조치입니다.

| 구성 요소 | 주요 기능 | 사용 사례 |

| Elasticsearch | 로그 데이터 저장 및 실시간 검색 | 이상 탐지, 성능 분석 |

| Logstash | 소스에서 로그 수집 및 변환 | 비정형 로그 정제, 필터링 |

| Kibana | 데이터 시각화 및 대시보드 제공 | 운영 모니터링, 보고서 생성 |

| Filebeat | 경량 로그 전달 에이전트 | 서버/컨테이너 로그 전송 |

| Elastic Security | 인증, 권한, 암호화 기능 제공 | 보안 로그 분석, 접근 제어 |

사례·비즈니스

ELK Stack를 사용하여 로그 관리 시스템을 구축할 때 필요한 기본 구성 요소는 무엇인가요?

ELK Stack은 Elasticsearch, Logstash, Kibana 세 가지 주요 구성 요소로 이루어져 있으며, 각각 로그 저장, 수집/파싱, 시각화 기능을 담당합니다. 필요에 따라 Beats를 사용해 가벼운 데이터 수집도 가능하며, 시스템 규모와 요구 사항에 맞춰 적절히 조합하여 배포해야 합니다.

로그 데이터를 Elasticsearch에 효율적으로 저장하기 위한 최적화 방법은 무엇인가요?

효율적인 저장을 위해서는 인덱스 템플릿을 사전 정의하고, 롤오버 정책 및 ILM(인덱스 수명 주기 관리)을 활용해 데이터의 저장 기간과 용량을 관리해야 합니다. 또한, 불필요한 필드는 제거하고, 적절한 매핑 설정을 통해 검색 성능과 저장 효율성을 동시에 확보할 수 있습니다.

Kibana를 활용한 로그 데이터 분석 시 가장 유용한 기능은 무엇인가요?

Kibana는 시각화 대시보드, 디스커버리 기능, 쿼리 기반 필터링 등을 통해 로그 데이터를 직관적으로 분석할 수 있도록 지원합니다. 특히 실시간 모니터링과 이상 탐지 기능은 운영 환경에서 문제를 신속히 파악하고 대응하는 데 매우 유용합니다.

Logstash와 Beats 중 어떤 도구를 로그 수집에 사용해야 하나요?

Logstash는 강력한 필터링 및 변환 기능을 제공하지만 리소스 소모가 크며, Beats는 가볍고 특정 유형의 데이터 수집에 최적화되어 있습니다. 일반적으로 간단한 로그 전송에는 Beats를, 복잡한 파이프라인 처리가 필요할 경우 Logstash를 조합하여 사용하는 것이 효율적입니다.