웹 상의 데이터 수집을 위한 크롤링 봇은 목적으로 활용되지만, 사이트 운영자들은 종종 이를 차단하려는 노력을 기울인다. 이에 따라 일부 사용자나 개발자들은 을 탐구하게 된다. 그러나 이러한 기법의 사용은 단순한 기술적 도전을 넘어 법적·윤리적 문제를 야기할 수 있다. 본 글에서는 을 중심으로, 데이터 접근의 정당성, 개인정보 보호, 웹사이트 이용 약관 준수 등을 종합적으로 살펴보고자 한다. 이를 통해 기술적 가능성과 책임 있는 사용 사이의 균형을 모색한다.

크롤링 봇 차단 우회 기법과 윤리적 고려사항: 기술적 접근과 책임 있는 활용

웹 크롤링은 데이터 수집 및 분석에 유용한 기술이지만, 웹사이트 운영자가 설정한 접근 제한을 무시하거나 우회하는 행위는 법적·윤리적 논란을 야기할 수 있다. 크롤링 봇 차단 우회 기법과 윤리적 고려사항은 단순히 기술적 가능성에 그치지 않고, 사용자가 어떤 기준과 책임 하에 해당 기술을 활용하는지가 핵심이다. 많은 웹사이트는 robots.txt, CAPTCHA, IP 차단, 속도 제한 등을 통해 크롤러의 접근을 통제하며, 이를 고의로 우회하는 것은 서비스 약관 위반 또는 컴퓨터 범죄로 간주될 수 있다. 따라서 개발자나 연구자는 기술적 우회 방법을 숙지함과 동시에, 데이터 소유자의 권리를 존중하고 투명한 목적 하에 활용해야 한다. 이는 단순한 기술적 문제를 넘어, 디지털 시민으로서의 책임과 직결된다.

크롤링 봇 차단을 우회하는 일반적인 기술적 방법

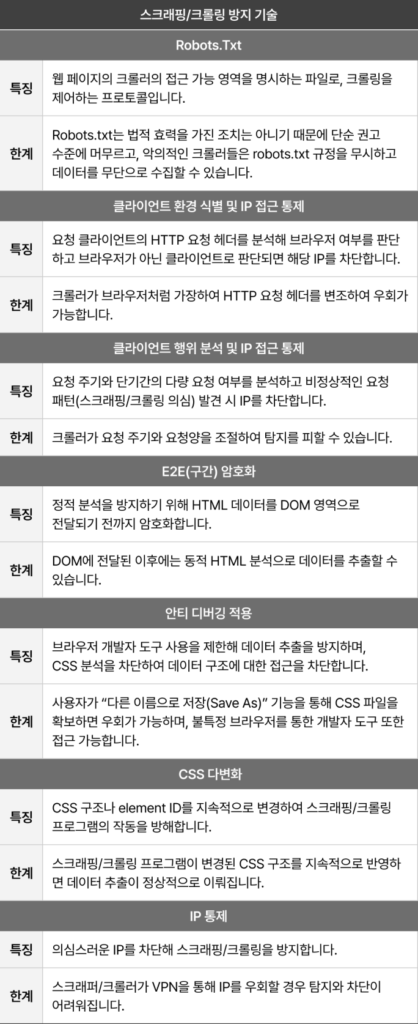

웹사이트는 방식으로 자동화된 크롤러의 접근을 제한한다. 이에 대응하여 크롤링 봇 차단 우회 기법과 윤리적 고려사항을 고려한 기술적 접근법으로는 사용자 에이전트(User-Agent) 변경, IP 로테이션, 헤더 조작(Referer, Accept-Language 등), 지연 시간 적용, JavaScript 렌더링 엔진(Selenium, Puppeteer 등) 활용 등이 있다. 특히 최신 웹사이트는 동적 콘텐츠를 제공하기 위해 JavaScript 기반 프레임워크를 사용하므로, 정적 HTML만을 파싱하는 전통적 크롤러는 무력화된다. 이 경우, 실제 브라우저를 에뮬레이션하는 도구를 사용해 렌더링된 DOM을 수집해야 한다. 그러나 이러한 기법은 서버 자원을 과도하게 소모시킬 수 있어, 비윤리적 또는 비합법적 사용으로 이어질 위험이 있다.

robots.txt의 역할과 무시 시 발생할 수 있는 문제

robots.txt 파일은 웹사이트 소유자가 크롤러에게 허용 또는 비허용 경로를 명시하는 표준 프로토콜이다. 이는 법적 구속력은 없지만, 업계에서 널리 존중되는 윤리적 규범이다. 크롤링 봇 차단 우회 기법과 윤리적 고려사항의 측면에서 robots.txt를 무시하는 행위는 명시적 거부에도 불구하고 데이터를 수집하는 것으로 간주될 수 있다. 예를 들어, 특정 디렉터리에 ‘Disallow: /private/’라고 명시된 경우, 이를 크롤링하는 것은 웹사이트 운영자의 의도를 명백히 위반하는 것이다. 법적으로는 미국의 CFAA(Computer Fraud and Abuse Act)나 유럽의 GDPR 등에서 이 같은 행위를 불법 접근 또는 데이터 남용으로 해석할 수 있다.

윤리적 크롤링을 위한 가이드라인

윤리적 크롤링은 단순히 기술적 제한을 피하는 것이 , 데이터 소유자의 권리와 시스템 안정성을 고려한 책임 있는 접근을 의미한다. 크롤링 봇 차단 우회 기법과 윤리적 고려사항을 균형 있게 고려하기 위해선 다음과 같은 원칙을 준수해야 한다. 첫째, robots.txt를 반드시 확인하고 이를 존중할 것. 둘째, 요청 빈도를 낮추어 서버 과부하를 방지할 것. 셋째, 민감하거나 개인정보가 포함된 콘텐츠는 절대 수집하지 말 것. 넷째, 크롤링 목적을 명확히 하고, 가능하면 웹사이트 운영자에게 사전 허가를 요청할 것. 이러한 가이드라인은 법적 리스크를 줄일 뿐만 , 데이터 생태계의 신뢰성을 높이는 데 기여한다.

법적 책임과 크롤링 관련 판례

크롤링 활동은 특정 조건 하에서 법적 책임을 초래할 수 있다. 대표적인 사례로는 미국의 HiQ Labs v. LinkedIn 사건이 있다. 이 사건에서 HiQ는 LinkedIn의 공개 프로필을 크롤링했고, LinkedIn은 이에 대해 차단 조치를 취했다. 법원은 HiQ의 크롤링이 CFAA 위반이 고 판결하며, 공개 데이터에 대한 접근 권리를 인정했다. 그러나 이는 예외적 판례이며, 대부분의 경우 비공개 데이터, 로그인 후 접근 가능한 콘텐츠, 또는 명시적으로 차단된 경로를 크롤링할 경우 법적 제재를 받을 수 있다. 따라서 크롤링 봇 차단 우회 기법과 윤리적 고려사항을 무시한 기술적 접근은 심각한 법적 결과를 초래할 수 있다.

윤리적 크롤링과 기술적 우회 간의 균형

기술적으로 가능한 우회 방법을 사용하는 것이 반드시 정당화되지 않는다. 크롤링 봇 차단 우회 기법과 윤리적 고려사항은 상호 보완적 관계에 있으며, 기술적 수단은 윤리적 틀 안에서만 정당성을 가진다. 예를 들어, 학술 연구 목적으로 제한된 데이터를 수집할 때, 기술적 우회가 필요하더라도 해당 목적의 정당성, 데이터 최소화 원칙, 비식별화 처리 등을 반드시 고려해야 한다. 기술 개발자와 연구자는 단순한 데이터 확보 이상의 책임을 지며, 이는 디지털 윤리의 핵심 요소로 평가된다. 따라서 우회 기법 사용 전에는 항상 목적, 범위, 투명성, 책임성의 네 가지 축을 점검해야 한다.

| 우회 기법 | 기술적 설명 | 윤리적 위험도 |

| User-Agent 스누핑 | 봇임을 숨기기 위해 브라우저 흉내 | 중간 (의도적 속임 포함) |

| IP 로테이션 | 여러 IP 주소를 번갈아 사용해 차단 회피 | 높음 (DoS 유사 행위 가능성) |

| JavaScript 렌더링 | 동적 콘텐츠 로드 후 크롤링 | 낮음~중간 (사용 목적에 따라 다름) |

| 헤더 조작 | Referer, Accept 등으로 인간 사용자 흉내 | 중간 (의도적 기만 요소) |

| 지연 시간 적용 | 요청 간격을 늘려 서버 부하 감소 | 낮음 (권장되는 윤리적 방법) |

사례·비즈니스

크롤링 봇 차단을 우회하는 기법에는 어떤 것들이 있나요?

크롤링 봇 차단을 우회하기 위해 사용되는 기법으로는 IP 로테이션, 헤더 조작, 지연 시간 삽입, 그리고 브라우저 자동화 도구 활용 등이 있습니다. 이러한 기법들은 서버의 차단 메커니즘을 피하기 위해 사용되지만, 웹사이트의 이용 약관이나 로봇 배제 표준(robots.txt)을 위반할 가능성이 있어 주의가 필요합니다.

크롤링 봇 차단 우회가 항상 불법적인가요?

크롤링 봇 차단 우회가 항상 불법이라고 단정할 수는 없습니다. 그러나 해당 웹사이트의 이용 약관이나 서비스 정책을 위반하는 경우, 민형사상 책임을 질 수 있습니다. 특히 비공개 데이터나 저작권으로 보호된 콘텐츠를 무단으로 수집하는 행위는 법적 문제로 이어질 수 있습니다.

윤리적인 웹 크롤링을 위한 기본 원칙은 무엇인가요?

윤리적인 웹 크롤링을 위해서는 먼저 robots.txt 파일을 확인하고, 해당 사이트의 크롤링 정책을 존중해야 합니다. 또한, 서버에 과도한 부하를 주지 않도록 적절한 요청 속도를 유지하고, 수집 목적과 범위를 명확히 하여 투명성과 책임성을 유지하는 것이 중요합니다.

크롤링 봇 차단 우회 시 고려해야 할 윤리적 문제는 무엇인가요?

크롤링 봇 차단 우회 시에는 개인정보 보호, 데이터 소유권, 그리고 서버 자원 남용과 같은 윤리적 문제가 발생할 수 있습니다. 특히 사용자 동의 없이 데이터를 수집하거나, 웹사이트 운영에 지장을 주는 행위는 윤리적 책임을 심각하게 훼손할 수 있으므로 반드시 피해야 합니다.